训练动物玩《我的世界》的技巧本质上与训练人工智能的原则是相同的:

- 基于上下文的强化学习:

每当Kanzi在游戏中达到标记的里程碑时,他就会得到一个水果或花生,激励他继续遵循游戏中的规则。

- RLHF:

Kanzi并不理解人类的语言,但它能看到训练人员为他加油打气,还会偶尔给出回应。来自训练人员的欢呼给了Kanzi一个强烈的信号:它走在正确的道路上。

- 模仿学习:

训练员为Kanzi演示了如何完成任务之后,它就立即掌握了相关操作的含义。演示的效果远远超出比单独使用奖励的策略。

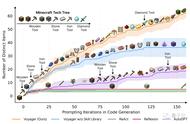

- 课程学习(Curriculum learning):

训练员和Kanzi从非常简单的环境开始,逐步教导Kanzi掌握控制技能。最后,Kanzi能够穿越复杂的洞穴、迷宫和下界。

不仅如此,即便是使用了类似的训练技巧,动物的视觉系统就能在极短的时间内识别和适应新的环境,而AI视觉模型则会花费更多的时间和训练成本,甚至常常难以达到理想效果。

我们再次陷入莫拉维克悖论(Moravec's paradox)的深渊:

人工智能与人类的能力表现相反。在我们认为无需思考或作为本能的低级智能活动中(如感知和运动控制),人工智能表现很糟糕。但在需要推理、抽象的高级智能活动中(如逻辑推理和语言理解),人工智能却很容易超越人类。

这正好对应了这个实验呈现的结果:

我们最好的人工智能(GPT-4)在理解语言方面接近人类水平,但在感知、识别方面远远落后于动物。

网友:原来猩猩打游戏也会生气

Kanzi和LLMs都可以玩《我的世界》,但Kanzi的学习方式和LLMs之间存在着不可小觑的差异,我们要注意这一点。

面对Kanzi优异的学习能力,网友们开始了恶搞。

有人预见6年以后的世界将成为猩球大战......

或者是猩猩喝可乐,融入人类社会......

甚至马老板也中枪了,被做成了「猴版」马斯克。