1、分析如下代码,编译运行后的结果()

public static void main(String[ ] args){

Systes.out.println(1/2);

Systcm.out.println(l.0/2);

Systen.out.println(1.0/2.0);

}

A、0,0.5,0.5 B、1.0,0,0.5 C、0.5,0.5,0.5 D、0,0,0.5

2、分析如下代码,编译运行后的结果()

Public class Test1{

public static void main(String[ ] args){

Systes.out.println(init());

}

Public static int init(){

try{

return 1/0;

}catch (Exception e){

Systes.out.println(”Error”);

Return -1;

}finally{

Return 1;

}

}

}

A、-1 B、Error -1 C、Error 1 D、编译出错

3、Java中的HashMap是通过()方法来确定键值对的索引。

A put()

B hashcode()

C get()

D equals()

4下列有关Java的说法正确的是()

A String是最基本的数据类型

B float f=3.4是错误的

C启动一个线程是通过调用run()方法实现的

D Java允许多继承

E main主方法中必须通过new实例来访问非static变量。

F以上选项都错误

5.Scala中关于变量定义、赋值,错误的是( )

A.val a=3 B.val a:String=3 C.val b:Int=3;b=6 D.var b=”hello”;b=”123”

6.Scala中下列表达式不是过程的是( )

A.def foo(num:Int)={println(num*2)}

B.def foo(num:Int)={num}

C.def foo():Unit={println(“hello”)}

D. def foo():String={“hello”}

7.在Scala中若val t1=Array(1,3); val t2=Array(2,4),那么t2.zip(t1)返回的值是()

A.(1,2,3,4) B.((1,3),(2,4)) C.((1,2),(3,4)) D.((2,1),(4,3))

8.在Scala中何种情况下赋值语句x=y=1是合法的(

A.val x={} B.var x=1 C.var x= “text” D.以上选项都是错误的

9关于Scala中trait 和Java中的Interface描述正确的是()

A.Scala trait不允许包含抽象方法和具体实现,而Java Interface 允许。

B.Scala和Java都不允许多重维承,但可以叠加多个特质和接口

C.Java只能在类层面上添加接口的实现,而Scala可以在类和对象层面上”混入”特质,其中对象加入特质时,用and

D.以上选项都是错误的

10关于Scala函数,下列说法正确的是()

A.函数是”头等公民”,就和数字一样

B.支持非具名函数,也即匿名函数

C.可以将函数设为另一个函数的参数

D.以上答案都是错误的

11在Centos 6中,查询本机IP地址的命令是()

A. ipconfig B. ip addr C. ifconfig D. ip

12在Linux系统中查询本机内存的命令是()

A.free-m B.df-h C.fdisk-l D.top

13在Linxu系统中start.sh文件的权限为:-rw-r--r--,下列哪条命令可使属主具有可执行权限()

A.chmod 644 start.sh

B.chmod 744 start.sh

C.chmod X start.sh

D.chmod U X start.sh

14 在Linux系统中的w编辑器,下列的命令表示强制保存的是( )

A :q B :wq C :q! D :wq!

15 下列表示Redis的说法正确的是( )

A Redis是一个基于内存的高性能Key Value数据库

B Redis通过PING命令来测试客户端与Redis服务器的连接是否正常

C Redis3版本不支持master-slave模式

D Redis3支持事务

E Redis 3版本提供两种持久化方法:Redis Database和Append-only fle

16 在Redis-cli中执行以下命令,

hset person name xiaowang

hset person age 27

hmset person company bank deployment IT

获取key-person全部字段和字段值的命令是( ),其共有( )个字段(field)

A getall person,3 B hget person,4 C hgetall person,3 D heetall person,4

17 下列属于 Hadoop生态组件的有( )

A HBase B Hive C Spark D Tez E Kafka F Strom

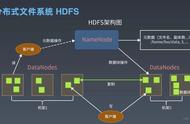

18 Hadoop-1.x与Hadoop-2.x中HDFS的block size默认是( )

A 64M 64M B 64M 128M

C 128M64M D128M 128M

19 HDFS是一个分布式文件系统,其适合的读写任务是( )

A一次写入,一次读取 B 一次写入,多次读取

C多次写入,一次读取 D 多次写入,多次读取

20 下列关于MapReduce的说法正确的是( )

A 如果输出目录已存在,或者输入路径已存在,那么MR程序将抛出异常。

B shuffle是指Map输出传给Reducer输入的过程,其是MR优化的重点。

C 在shuffle中可以加入combiner,其意义在于使map输出更紧凑,传给reducer的数据更少。

D 如果map函数的输出类型是list(K1,V1),那么reducer函数的输入类型必须是(K2,list(V1))-

21 下列关于Yarn的说法正确的是( )

A ResourceManager ApplicationMaster、NodeManger、Container、JobTracker.

TaskTracker都是Yarn的组成部分。

B ResourceManger是Yarn的全局资源管理器。

C NodeManger是每个节点上的资源和任务管理器。

D JobTracker协助ResourceManger进行资源管理。

22. HBase RowKey的设计原则是()

A.长度原则

B.胜列原则

C.唯一原则

D.业务原则

23.下列关于HBase的说法正确的是()

A.HBase是一个分布式的、面向性的非结构化数据库。

B.HBase有两个默认的表空间default、hbase。

C.HBase集群中可以启动多个HMaster,这些HMaster可以并行运行。

D.HRegionServer负责响应用户I/O请求,向HDF5中读写数据。

24.下列属于Hive执行引擎的是()

A.HBase

B.MR

C.Tez

D.Spark

25.下列关于Hive的说法正确的是()

A.Hive不支持从Linuxk文件系统中向表中导入数据。

B.Hive能使用from insert.select where 结构将一个数据表抽取的数据插入到另外不同的表和分区中。

C.Hive不支持CTE结构。

D.Hive删除外部表,只会删除表数据,不会删除元数据。

26.下列关于Kafa的说法正确的是()

A.Kafa是一个分布式发布订阅消息系统,由Linkedin 最初开发。

B.对于阿一个topic,只能有一个消费者。

C.同一个topic的partition只能增加,不能减少。

D.topic的pantion由多个segment组成。一个segment由index索引文件和log数据文件组成。

27.下列关于Storm的说法正确的是()

A.nimbus与supervisor之间是通过rookeepr相互通信的

B.Storm不支持事务

C.Storm的spout具有tall特性

D.storm有多种类型的stream grouping策略,其中shuffle grouping表示随机分组。

28.Spark支持的分布式部署方式是()

A.standalone

B.Spark on mesos

C.Spark on Yarn

D.Spark on local

29.Spark中RDD(弹性分布式数据集)有两种类型的操作:Transform操作和Action操作。下列方法属于Transform操作的是()

A.Map() B.top()

C.reduce() D.filter()

30 下列关于RDD的说法正确的是

A、 Transform操作只会由一个RDD生成另一个新的RDD.不会进行实质计算,只有第一次Action时, 才会真正计算。

B、 Spark用户能够通过SparkContext 的 parallelize(seq)方法创建RDD.

C、 Spark通过读取外部数据,如HDFS. Hive等,创建RDD.

D、 Spark中RDD之间的依赖关系分为两种,窄依赖和宽依赖。其中的窄依赖是指多个子RDD的分区依赖一个父RDD的分区。

二 在CentOS 7中,/home/centos/txt的方容如下:

aaa bbb abc

ccc aaa ddd

aab eee fff

aaa ggg hhh

(1)查找以aaa开头的行,要求一行命令

(2)将以aaa开头的那一行中的全部a换成大写A,要求一行命令。

三 在Linux的/root/text.txt中内容如下:

aIsjdlfkjsdlkfjd

alskdjf

laksdjfoiewjoijwf

lskdsldkj

lasef jiojefIkjdsjlk

eowjflakjsdlfkj

liaeaw

编写Scala代码,将test.txt中所有字符数大于12的单词打印出来。