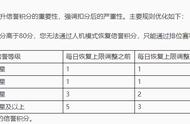

表 4:AI 与不同顶级人类玩家的比赛结果

基准比较

可以看到,用论文新方法训练的 AI 的表现显著优于多种baseline方法。

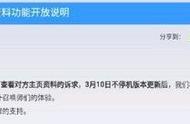

图 4:击败同一基准对手的平均时长比较

训练过程中模型能力的进展

图 5 展示了训练过程中 Elo 分数的变化情况,这里给出的是使用射手英雄「狄仁杰」的例子。可以观察到 Elo 分数会随训练时长而增长,并在大约 80 小时后达到相对稳定的水平。此外,Elo 的增长率与训练时间成反比。

图 5:训练过程中 Elo 分数的变化情况

控制变量研究

为了理解论文方法中不同组件和设置的效果,控制变量实验是必不可少的。表 5 展示了使用同样训练资源的不同「狄仁杰」AI 版本的实验结果。

表 5:控制变量实验

4、未来工作

本文提出的框架和算法将在未来开源,而且为了促进对复杂游戏的进一步研究,腾讯也将在未来把《王者荣耀》的游戏内核提供给社区使用,并且还会通过虚拟云的形式向社区提供计算资源。

雷锋网 AI 科技评论报道。雷锋网雷锋网

,