在信息时代,我们常常希望人工智能能够学到更多的知识,变得更加智能。但你是否想过,有时候让机器"忘记"一些它学到的东西,也是一件很重要的事?

随着用户隐私保护意识的提高和相关法律法规的出台,用户有权要求企业或机构删除其个人数据。对于使用机器学习方法的应用来说,这就意味着需要让训练好的模型"忘掉"某些用户的数据,让模型"机器遗忘"。但是,对已经训练好的模型进行"减法"远比"加法"困难。因为在机器学习的过程中,每个样本对模型的影响是交织在一起的,很难精准地"剔除"某个数据的影响。

除了保护隐私,机器遗忘在修正有偏见的模型、提高模型鲁棒性等方面也有重要作用。本文将带您全面了解"机器遗忘"这一崭新的研究方向,介绍其主要挑战和代表性的技术方法。让我们一起探索这一有趣而又充满潜力的领域,了解"忘记"也是人工智能需要学习的一门学问。

论文标题:

Machine Unlearning: A Comprehensive Survey

论文链接:

https://arxiv.org/pdf/2405.07406

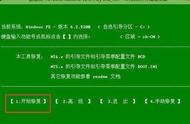

3.5研究测试:

hujiaoai.cn

4研究测试:

askmanyai.cn

Claude-3研究测试:

hiclaude3.com

在信息爆炸的时代,机器学习模型变得越来越强大,但也面临着新的挑战——如何"忘记"不再需要的数据和知识。本文将带你探索"机器遗忘"这一前沿研究方向。

让机器学会"忘记"有多难?传统的机器学习模型就像一个"海绵",不断吸收数据,但却不知道如何"挤压"出不需要的部分。当用户要求删除个人数据时,简单地从训练集中移除这些数据是不够的,因为模型已经从这些数据中学到了知识,形成了某种"记忆"。

要让模型真正"忘记"某些数据,面临三大挑战:

- 训练过程的随机性(Stochasticity of training):模型训练过程中引入的随机性(如随机初始化、数据采样、mini-batch梯度下降等),导致每次训练的结果都不完全相同,给"遗忘"某些数据带来困难。即便使用相同的训练数据,重新训练得到的模型也可能与之前的模型有差异。

- 训练过程的增量性(Incrementality of training):模型通过增量方式不断学习新数据,每个数据对模型的影响相互交织。前面学习的数据会影响后续数据对模型的作用。当要"遗忘"某些数据时,很难准确估计和剥离这些数据对模型的影响,因为它们已经间接地影响了其他数据的学习过程。

- 灾难性遗忘(Catastrophic forgetting):当要"遗忘"的数据量较大时,通过各种机器遗忘技术得到的新模型性能可能大幅下降,其效果远逊于重新训练的模型。这种令人惊讶的性能下降被称为"灾难性遗忘"。如何在避免隐私泄露的同时,尽量减轻机器遗忘带来的副作用也是一大挑战。

此外,机器遗忘还面临如何衡量遗忘效果的问题。传统的模型评估指标(如准确率)无法直接度量隐私泄露风险。需要新的评估指标来权衡模型性能和隐私保护强度,这也是一个亟待探索的方向。

综上,让机器学会"忘记"绝非易事。研究者们需要攻克随机性、增量性、灾难性遗忘等难题,并设计出科学的评估指标,才能实现高质量的机器遗忘。这需要机器学习、隐私保护、安全等多个领域的交叉探索和创新。

机器遗忘技术大比拼面对机器遗忘的重重挑战,研究者们提出了多种解决方案。总的来说,主流的机器遗忘技术可分为两大类:精准遗忘和近似遗忘。

精准遗忘:给记忆"做减法"精准遗忘的核心思想是:与其在完整模型上直接"遗忘",不如先把模型"分解"成多个部分,再在局部进行遗忘,最后再把它们"组装"起来。这样可以在一定程度上规避随机性和增量性带来的影响。

以SISA(Sharded, Isolated, Sliced, and Aggregated)训练方法为例,它将训练数据分成多个独立的"碎片",并在每个碎片上训练一个独立的子模型。当需要遗忘某些数据时,只需找到对应的碎片,重新训练该碎片上的子模型,而其他子模型不受影响。最后,再将各个子模型聚合起来,得到完整的"遗忘后"模型。