类似地,一些研究将模型划分为多个独立的模块,每个模块只学习一部分数据的特征。遗忘时只需重新训练相应的模块即可。还有一些工作利用决策树、随机森林等易于分解的模型结构,实现高效的机器遗忘。

近似遗忘:估计并抵消"记忆"影响近似遗忘则试图直接从已训练好的完整模型入手,估计要遗忘的数据对模型的影响,并从模型中"减去"这种影响。由于这种方法只需操作一个完整模型,因此往往更简单和高效。但另一方面,由于很难准确估计出某些数据对模型的精确影响,遗忘的效果可能没有精准遗忘那么"干净利落"。

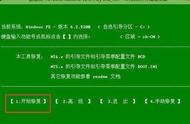

下图展示了在分类模型中添加或移除一个数据点时的变化情况。当一个有影响力的数据点出现时,它通常会推动分类线向前移动,以识别该数据点,如图(b)所示。当需要移除这个有影响力的数据点时,机器遗忘机制必须将模型恢复到未训练该特定数据点的原始状态,如图(c)所示。然而,当仅遗忘一个几乎没有影响力的数据点时,该数据点可能对模型几乎没有影响,在这种情况下,遗忘后的模型可能与原始训练的模型相比没有变化,如图(d)所示。

常见的近似遗忘方法包括:基于影响函数的方法,它们估计每个训练数据对模型的贡献,并在遗忘时对这些贡献进行反向操作;基于梯度的方法,它们将遗忘目标表示为一个约束优化问题,通过特定的梯度更新策略来不断"消除"某些数据的影响;还有一些工作利用黑塞矩阵或Fisher信息矩阵来近似每个数据的影响。

近似遗忘要解决的核心问题是:如何在高效地遗忘的同时,尽量控制遗忘导致的性能损失。一些改进方法包括:调节遗忘力度的平衡因子、设定遗忘数据比例的上限、通过特殊的正则化项限制遗忘过程中的模型"跳变"等。这有点类似"调药方",即根据病情和副作用来动态调整药量。

差分隐私:从"源头"上防止隐私泄露除了在事后通过机器遗忘来"擦除"模型中的隐私数据,另一种思路是从一开始就训练出"隐私保护友好"的模型。差分隐私(Differential Privacy)正是这样一种理念,它通过在模型训练时引入随机噪声,使得模型输出对于有无某条数据变得不敏感,从而从源头上防止隐私泄露。

差分隐私的核心思想是,如果一个模型在训练时满足差分隐私,那么攻击者通过观察模型的输出,将无法判断某个特定的数据点是否在训练集中。形式化地说,一个机器学习算法满足(,)-差分隐私,当且仅当对于任意两个相邻数据集和′(即只相差一条数据),它们的输出分布()和(′)是-相似的,且这种相似性以至少1−的概率成立。直观地说,越小隐私保护强度越大。

为了实现差分隐私,常用的方法是在训练过程中加入Laplace噪声或高斯噪声,以掩盖个体数据点的影响。还有一些工作利用梯度裁剪、模型压缩等技术,在保证隐私的同时尽量降低噪声对模型性能的影响。

一些研究尝试将差分隐私与机器遗忘相结合,用差分隐私的随机噪声取代需要遗忘的数据,从而避免了复杂的遗忘步骤。例如可以在模型训练时对梯度引入差分隐私噪声,这样训练得到的模型对于某些数据天然具有"遗忘性"。还可以利用差分隐私的思想来指导遗忘过程,通过隐私预算来控制遗忘对模型的影响。总的来说,差分隐私为机器遗忘提供了新的视角和方法。

当然,在引入噪声的同时保证模型的效用仍然是一个挑战。如何权衡隐私保护强度和模型性能,如何设计更加智能、自适应的噪声机制,如何在联邦学习、在线学习等复杂场景下实现差分隐私,都是值得进一步探索的问题。此外,差分隐私虽然提供了强大的隐私保护,但并非对所有攻击都是"免疫"的。研究者们仍在不断探索差分隐私的边界,并设计更加安全、鲁棒的机器学习框架。

"机器遗忘"实验室为了验证机器遗忘的有效性,研究者们在多个基准数据集和实际任务上进行了广泛的实验。

在图像分类任务上,研究者们使用了MNIST手写数字数据集、CIFAR-10/100小型图像数据集、ImageNet大型图像数据集等。通过随机选取一部分训练样本作为需要遗忘的数据,然后对比原始模型、重新训练的模型和机器遗忘的模型在测试集上的准确率,可以评估机器遗忘的有效性。一般来说,重新训练的模型可以视为"完美遗忘"的参照。实验结果表明,许多机器遗忘方法都能在保持较高准确率的同时,有效地"忘记"指定的训练数据,其性能接近重新训练的模型。