网络框架如上图所示,实现过程可分为以下四步:

- 1. 使用图像语义分割网络,获得图像的语义特征;

- 2. 检测子网络 - 1 从原始点云中得到目标的三维候选框;

- 3. PACF 模块融合点云特征和图像语义特征;

- 4. 检测子网络 - 2 得到最终的三维检测结果。

论文 3《EPNet: Enhancing Point Features with Image Semantics for 3D Object Detection》提出了一种新的融合模块,在不需要任何图像注释的情况下,对具有语义特征的点特征进行逐点增强。该研究设计了一个端到端的可学习框架 EPNet 来集成两个组件。在 KITTI 和 SUN-RGBD 数据集上进行的大量实验表明,EPNet 优于当前最优方法。其网络结构点云分支是 point encoder-decoder 结构,图像分支则是一个逐步 encoder 的网络,并且逐层做特征融合。

论文地址:https://arxiv.org/pdf/2007.08856.pdf

网络整体框架如下图所示:

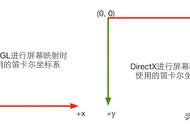

点云特征和图像特征融合过程如下图所示:

融合过程由三部分组成:grid generator、image sampler 和 LI-Fusion layer。

- 1. 根据三维激光与图像的外参,grid generator 将三维激光的每一个点投影到原始图像上;

- 2. image sampler 利用图像特征图与原始图像的比例关系以及双线性插值,得到对应的图像特征图;

- 3. 为了减少图像的遮挡以及深度不确定性对融合造成的影响,LI-Fusion layer 利用点云特征估计对应图像特征的重要程度并筛选,具体是将点云特征与图像特征经过若干操作学习得到权重值,权重值与图像特征相乘再与点云特征串联作为最后的融合特征。

论文 4《CLOCs: Camera-LiDAR Object Candidates Fusion for 3D Object Detection》提出了一种新颖的 Camera-LiDAR 目标候选(CLOC)融合网络。CLOC 融合提供了一种低复杂度的多模态融合架构,显著提高了单模态检测器的性能。CLOC 在非最大抑制 (NMS) 之前对任意 2D 和任意 3D 的组合输出候选项进行操作,并被训练利用它们的几何和语义一致性,以产生更准确的最终 3D 和 2D 检测结果,最后采用 maxpooling 的方式选择最终的融合结果。