引用

Wang G, Zuluaga M A, Li W, et al. DeepIGeoS: a deep interactive geodesic framework for medical image segmentation[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 41(7): 1559-1572.

摘要

准确的医学图像分割对于诊断、手术计划和许多其他应用至关重要。卷积神经网络(CNN)已成为最先进的自动分割方法。但是,全自动结果可能仍需要改进,以变得足够准确和鲁棒,并可用于临床。我们提出了一种基于深度学习的交互式细分方法,以改善通过 CNN 自动获得的结果,并减少精炼过程中的用户交互,以实现更高的准确性。我们使用一个 CNN 来获得初始的自动细分,并在其上添加用户互动以指示错误细分。另一个 CNN 会将用户与初始细分的互动作为输入,并提供精确的结果。我们建议通过测地距离转换将用户互动与 CNN 结合起来,并提出一个分辨率更好的网络,以提供更好的密集预测。另外,我们将用户交互作为硬约束,集成到可反向传播的条件随机字段中。我们在胎儿 MRI 的 2D 胎盘分割和 FLAIR 图像的 3D 脑肿瘤分割的背景下验证了提出的框架。实验结果表明,与传统的交互式方法相比,我们的方法相对于自动 CNN 有了很大的改进,并获得了可比甚至更高的准确性,而且用户干预更少,时间更少。

1.导言

解剖结构的分割是图像诊断、解剖结构建模、手术规划和引导等一系列医学图像处理应用的重要任务。然而,全自动分割方法很少能获得足够精确和健壮的结果,从而在临床上有用。这通常是由于图像质量差(有噪声、部分容积效应、伪影和低对比度)、患者之间的巨大差异、病理学带来的不均匀表现以及临床医生之间协议的变化导致给定结构边界的不同定义。为了解决自动分割方法的局限性,交互分割方法是可取的,因为它们在许多应用中允许更高的精度和鲁棒性,由于为切分提供手动注释既费时又费力,因此一个高效的交互式切分工具在实际应用中具有重要意义。

我们提出了一种新的交互式方法,利用深度学习进行 2D 和三维医学图像分割。首先是一个两阶段的流水线,第一个 CNN 自动获得一个初始分割,第二个 CNN 通过利用少量的用户交互来细化初始分割,我们将其编码为测地距离图。我们将提出的交互式分割方法称为深度交互式测地框架(DeepIGeoS)。

DeepIGeoS 的特性如下:首先,它使用一个更强大的基础学习模型,即 CNN 与自动特征学习,以从一个大的训练集利用知识。其次,它需要更少的用户交互,因为该方法从高质量的自动分段开始,在细化阶段只需要用户提供的点击或简短的涂鸦。第三,它是高效的,能够实时响应用户交互,这导致了非常短的用户时间。

本文的主要贡献有四个方面:1)提出了一种基于深度 CNN 的交互式 2D 和三维医学图像分割框架;2) 为了使 CNNs 能够高效、准确地进行交互式分割,我们分别提出了两种新的 2D 和三维图像分割网络;3) 我们建议将用户与 CNNs 的交互转换成测地距离图作为 CNNs 输入的一部分,并将其作为可训练条件随机场(Conditional Random Field - CRF)的约束条件;4) 我们证明了 CNNs 在交互式医学图像分割中具有最先进的性能,比现有的方法花费更少的用户工作和时间。

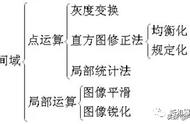

2.方法

图 1 描述了用于深度交互切分的 DeepIGeoS。为了最小化用户交互的数量,我们提出了一个两阶段的框架:在第一阶段,这是一个自动切分问题,需要快速推理,一个 CNN(P-Net)自动完成一个初始切分。在第二阶段,用户检查初始分割并给出一些交互(点击和简短的涂鸦)来指示错误分割的区域,第二个 CNN(R-Net)通过将原始图像、初始分割和用户交互作为输入来细化分割。用户可以通过 R-Net 多次单击/涂鸦来优化结果。P-Net 和 R-Net 使用了一种保持分辨率的结构,这种结构可以在不损失分辨率的情况下从一个大的感受野捕获高层次的特征。除了在输入维度上的差异外,它们的结构相同。其每次给出新的用户交互时,都会重新训练学习模型。

为了使分割结果在空间上更加一致,并使用涂鸦作为硬约束,P-Net 和 R-Net 都与 CRF 相连接,CRF 被建模为一个 RNN(CRF-Net),从而可以通过反向传播与 P-Net/R-Net 联合训练。

图 1. 两阶段交互式分割框架概述。第 1 阶段:P-Net 自动提出初始分段。第 2 阶段:R-Net 通过用户交互来细化细分,表示细分错误。

图 2 示出了用户交互的测地距离变换的示例。用户交互的测地距离图和初始自动分割的大小与 I 相同。将它们与 I 的原始通道串联,得到具有 CI 3 通道的级联图像,作为细化网络 R-net 的输入。

2.1基于用户交互的测地距离图

在我们方法的第 2 阶段,用户提供涂鸦来完善第 1 阶段 P-Net 获得的初始自动分割。涂鸦将一组像素标记为前景或背景。具有相同标签的互动被转换为距离图。测地距离有助于更好地区分具有不同外观的相邻像素,并提高同质区域的标签一致性。

图 2. 第 2 阶段 R-Net 的输入。(a)用户提供点击/涂鸦,以纠正初始自动分割的前景(红色)和背景(青色)(d) 和(e)分别是基于前景和背景相互作用的测地距离图。将原始图像(b)与初始自动分割(c)和测地距离图(d)、(e)通过通道拼接相结合,作为 R-Net 的输入。

2.2使用扩张卷积保持 CNN 分辨率

我们的方法中的 CNN 被设计为从一个大的感受野中捕捉高级特征,而不损失特征图的分辨率。它们是由 VGG-16 改编而成的,并使其具有分辨率保护功能。图 3 显示了 2D 和三维 P-Net 的结构。2D R-Net 使用与 2D P-Net 相同的结构,只是其输入通道数为 CI 3,并且在 CRF-Net 中采用了用户交互。为了获得感受野的指数级增长,我们删除了 VGG-16 最大池化和下采样层,并在每个区块中使用扩张卷积。

每个卷积层的跨度被设置为 1,每个区块的卷积输出通道数被设置为固定的数字 C。为了使用多尺度特征,我们将不同区块的特征连接起来,得到一个长度为 5C 的组合特征。这个特征被送入一个分类器,该分类器由两个附加层实现,如图 3a 中的第 6 块所示。CRF 由一个递归神经网络(CRF-Net)实现,它可与 P-Net 或 R-Net 联合训练。CRF-Net 为每个像素提供一个规则化的预测,并将其输入交叉熵损失函数层。

类似的网络结构被 3D P-Net/R-Net 用于 3D 分割,如图 3b 所示。为了减少三维图像的内存消耗,我们在分辨率保持层之前使用一个降采样层,并在连接层之前通过 1×1×1 卷积将块 1 到 5 的输出特征压缩 4 倍。