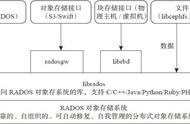

在创建CEPHFS时,要至少创建两个POOL,一个用于存放数据,另一个用于存放元数据。Mds只是负责接受用户的元数据查询请求,然后从osd中把数据取出来映射进自己的内存中供客户访问。所以mds其实类似一个代理缓存服务器,替osd分担了用户的访问压力,如下图:

七、fileStore与blueStore

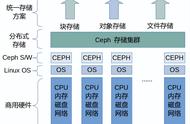

ceph 消息处理逻辑架构图

ceph后端支持多种存储引擎,以插件化的形式来进行管理使用,目前支持filestore,kvstore,memstore以及bluestore,目前在L版本以后默认使用的是bluestore,目前基本已经稳定

接下来对比一下

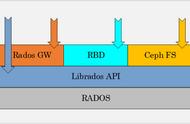

1)Firestore存在的问题是:

- 在写数据前需要先写journal,会有一倍的写放大;

- 若是另外配备SSD盘给journal使用又增加额外的成本;

- filestore一开始只是对于SATA/SAS这一类机械盘进行设计的,没有专门针对SSD这一类的Flash介质盘做考虑。

2)而Bluestore的优势在于:

- 减少写放大;

- 针对FLASH介质盘做优化;

- 直接管理裸盘,进一步减少文件系统部分的开销。

让我们看看filestore的逻辑架构