欢迎点击右上角关注小编,除了分享技术文章之外还有很多福利,私信“学习资料”可以领取包括不限于Python实战演练、PDF电子文档、面试集锦、学习资料等。

想必大家有一个问题。什么是词云呢?

词云又叫名字云,是对文本数据中出现频率较高的“关键词”在视觉上的突出呈现,形成关键词的渲染形成类似云一样的彩色图片,从而一眼就可以领略文本数据的主要表达意思。、

网页上有许多词云的效果图:

而且,目前有许多制作词云的工具:

但是作为一个学习Python的程序员来说,我更喜欢通过自己的编程去解决问题。

而且用Python制作词云只需十行代码就行了哦~

一起来看看吧!

代码块import matplotlib.pyplot as plt

from wordcloud import WordCloud

import jieba

text_from_file_with_apath = open('/Users/hecom/23tips.txt').read()

wordlist_after_jieba = jieba.cut(text_from_file_with_apath, cut_all = True)

wl_space_split = " ".join(wordlist_after_jieba)

my_wordcloud = WordCloud().generate(wl_space_split)

plt.imshow(my_wordcloud)

plt.axis("off")

plt.show()

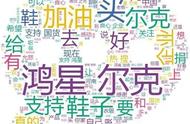

代码效果图:

下面咱们解析一下代码块:

1~3 行分别导入了画图的库,词云生成库和jieba的分词库;

4 行是读取本地的文件,代码中使用的文本是本公众号中的《老曹眼中研发管理二三事》。

5~6 行使用jieba进行分词,并对分词的结果以空格隔开;

7行对分词后的文本生成词云;

8~10行用pyplot展示词云图。

这是我喜欢python的一个原因吧,简洁明快。

当然,这只是一个简单得不能再简单得编程,实现的效果也非常简单

但是Python是一门开源的语言,这时候就体现出开源的特性了,任何人都能对一个项目加以修改,使项目不断的完善。

Github上有许多开源的项目,小编找到一个做词云的项目,链接如下:

https://github.com/amueller/word_cloud

咱们可以直接进入wordcloud.py 源码进行字体,词云效果进行修改。

源码解析:

wordcloud.py总共不过600行,其间有着大量的注释,读起来很方便。其中用到了较多的库,常见的random,os,sys,re(正则)和可爱的numpy,还采用了PIL绘图,估计一些人又会遇到安装PIL的那些坑.

生产词云的原理其实并不复杂,大体分成5步:

- 对文本数据进行分词,也是众多NLP文本处理的第一步,对于wordcloud中的process_text()方法,主要是停词的处理

- 计算每个词在文本中出现的频率,生成一个哈希表。词频计算相当于各种分布式计算平台的第一案例wordcount, 和各种语言的hello world 程序具有相同的地位了,呵呵。

- 根据词频的数值按比例生成一个图片的布局,类IntegralOccupancyMap 是该词云的算法所在,是词云的数据可视化方式的核心。

- 将词按对应的词频在词云布局图上生成图片,核心方法是generate_from_frequencies,不论是generate()还是generate_from_text()都最终到generate_from_frequencies

- 完成词云上各词的着色,默认是随机着色

词语的各种增强功能大都可以通过wordcloud的构造函数实现,里面提供了22个参数,还可以自行扩展。

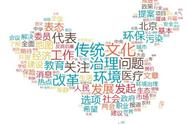

效果图:

小伙伴看了文章自己可以动手操作操作哦,是Python一个十分简单的项目呢。如果需要项目源码的小伙伴可以关注并私信小编“007”获取词云制作的源码哦!

,