胡安宁 周森

来源:《中国社会科学文摘》2024年第4期P15—P16

作者单位:复旦大学社会学系 浙江师范大学教师教育学院,原题《站在巨人肩膀上的初学者:社会科学研究中的生成式人工智能》,摘自《江苏社会科学》2024年1期

2022年底ChatGPT以及2023年初GPT-4的出现,让生成式人工智能成为全社会关注的焦点。作为一种通用式AI,生成式人工智能以惊人的算力学习数字世界的海量资料,生成具有高度可用性和似真性的文本、图像、音频、视频、软件代码等内容。在此背景下,生成式人工智能与哲学社会科学研究之间的关系也日渐成为学术界关注的重点。现有研究考察了生成式人工智能是否具有类似于人类的智能,是否能够成为社会科学研究的助力者乃至社会科学研究范式的改革者等关键问题。

社会科学经验研究过程要求理论和经验之间的有机结合。由于生成式人工智能的重要功能之一是对各种文本资料进行总结并生成“新”的内容,因此,当我们思考生成式人工智能和社会科学研究之间的关联时,一个很直接的思路便是,社会科学研究者是否能够利用生成式人工智能完成理论梳理方面的工作。换言之,当一个社会科学研究者围绕一个特定问题进行研究时,生成式人工智能可否帮助这位研究者更好地处理各种描述理论的文本信息。

回答这一问题,首先要厘清的是社会科学经验研究中的理论梳理需要具体做什么?简单而言,社会科学经验研究中我们需要围绕理论梳理做三点工作:其一,概念的辨析,即通过文献梳理,明晰经验研究中涉及的核心概念的具体意涵是什么。其二,理解概念之间的关系,即从理论文献的角度,帮助研究者理解为什么两个甚至多个概念之间存在某种实质性的关联,为什么这个关联不是虚假的。其三,在前面两点的基础上挖掘理论的空白点,由此提出创新性的理论论辩,也就是理论创新。基于这三点理论层面的任务,我们为了衡量生成式人工智能的理论工具性价值,设定三个询问任务:概念总结、概念关联和理论空白点挖掘。我们发现,采用生成式人工智能技术对社会科学研究的理论问题进行梳理的突出特点在于“总结而非论辩”。所谓总结,是基于既有资料进行一种内容的简化和聚焦。缺乏论辩是对既有文献的背景和不同研究之间的相互联系缺乏足够的把握。可见,生成式人工智能对于理论尚不能做到意义的理解和互相勾连。从这个角度来说,生成式人工智能产生的各种内容至少对于社会科学研究不能起到一个很好的“助研”的作用,因为其缺乏社会科学研究所需要的理论深度和广泛联系。

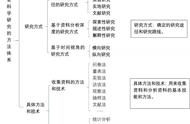

如果说理论层面的总结和凝练不能达到社会科学研究所需要的精细度和创新度,那么具体到研究方法层面呢?我们在面对已经构建好的研究问题时,是不是可以依赖生成式人工智能找到合适的方法并加以运用呢?这方面具有典型意义的一个案例就是代码撰写。对于很多量化社科研究者而言,在具体研究中面对特定数据时,需要根据研究问题通过特定的软件平台撰写代码、进行数据分析,并以此获得具有理论价值的经验结论。由于特定软件平台下的统计模型语句都是“固定”的,且存在大量的在线资料,那么完全可以在确知所使用的方法的前提下,通过生成式人工智能生成相关的代码。这方面我们同样通过具体的方法来测试ChatGPT。我们发现,生成式人工智能所产出的内容对于从事量化研究的人员非常友好。围绕特定的研究方法,生成式人工智能能够提供比较准确的方法解释以及在不同软件平台的实现代码。针对具体的研究问题,研究人员完全可以对生成式人工智能提供的一般性代码进行个性化修改,以完成自身的研究任务。但是,需要指出的是,生成式人工智能撰写的代码往往也遵循“拿来主义”的逻辑,对于方法本身的创新却缺乏足够的观照。

由于生成式人工智能是在对大量既有资料训练的基础上生成“新”的内容,因此在现有对生成式人工智能的反思中,一个被反复提及的问题是,一些存在于输入资料中的偏见和误差也可能会通过善于学习的人工智能转移到其生成的内容之中。据此,我们在这一部分的讨论中通过具体的实例考察生成式人工智能的这种偏误问题。

为了展示生成式人工智能潜在的研究偏误,我们选取一个具体的社会科学研究议题:一般信任。综合各种尝试,我们发现,对“一般信任”的研究希望可以获得一种大家看上去就想到社会一般成员的人像图片,但是通过输入不同的提示词所生成的大多数图片因为存在各种偏误而难以很好地满足这一需求。在个别情况下甚至出现了南辕北辙或者不知所云的情况。生成式人工智能生成的图片之所以出现这种局限,或许因为这样一种悖论:一方面我们希望通过图片来反映某种现实意义,因此为了产生这种图片,需要在提示词文本框中非常明确地把这种意义详细描述出来。但是,另一方面,如果我们可以做到这种意义的“完美”描述,完全可以直接采用语言的形式和被研究对象进行沟通,也就没有必要去生成图片来辅助研究了。

通过对生成式人工智能的各种“测试”,我们发现,对于社会科学研究,生成式人工智能在现有的技术能力下尚有不少局限,为了克服这些局限,至少需要在以下两个方向努力:技术进步和人工引导。

生成式人工智能的技术进步既涉及数据品质的提升也关系算法的优化。所谓数据品质,是指为了克服潜在的偏误,需要纳入更加“全面”而并不必然“更多”的资料。此外,各种造成潜在偏误的“误解”或者“歧视”本身也可以作为一个单独的数据维度纳入算法,以对输出结果进行修正。实际上,以人工智能技术来“修正”研究过程的偏误对于社会科学研究而言并不罕见,其在克服人类注意力持续时间有限、反应偏差或习惯化方面表现得尤为突出,从而可以提供偏见较少的资料。此外,人工智能技术也有助于克服模型偏差和样本选择偏差问题。这些既有的经验对于生成式人工智能技术可资借鉴。在算法提升方面,生成式人工智能技术需要将着力点放在探索理论与方法的增长点,而不仅仅是表面化的复现。这方面或许可以让算法在“做中学”,通过具体的研究过程来摸索社会科学的进路。此外,为了杜绝算法设计过程中的人为偏误,算法设计者需要对研究设计过程保持一种反思性。

除了自身的技术进步,生成式人工智能应用于社会科学研究不可或缺的是人为的引导和“培育”。在这方面,一个很重要的努力方向是把生成式人工智能放入社会科学研究范式之中,让人工智能做“社会科学”的事而不是日常生活中的事。例如,研究人员可以结合各自的专业知识,使用生成式人工智能来模拟参与者特征,生成假设并在人群中进行验证。此外,生成式人工智能的“黑匣子”性质阻碍了研究人员对其进行评估,也削弱了科研复制发现的能力。鉴于此,我们要倡导社会科学研究中使用的生成式人工智能像所有科学模型一样,以开源的形式展现。这意味着它们的算法和理想的数据可供所有人审查、测试和修改。只有保持透明度和可复制性,才能确保人工智能辅助的社会科学研究真正有助于我们理解人类经验。在对生成式人工智能进行人工引导的过程中,作为引导者的研究人员还需要恪守研究伦理,例如,如果研究者只寻求与他们预设的结论相一致的支持信息,这在无意中会进一步助长偏见。因此,当务之急是提升用于训练模型的数据的表征公平性。关于这一点,我们还需要警惕陷入“聪明反被聪明误,努力反被努力误,公正反被公正误”的窘境。这是因为社会科学的研究目标正是研究特定群体的特定社会文化偏见,模拟具体人群的具体行为并追溯其文化演变。出于公正的要求,现在的伦理约束要求工程师保护人工智能免受这些偏见的影响。这反而让人工智能技术进入一种“平庸”的客观和全面,没有尊重我们苦苦寻觅的、客观存在的“偏见”,远离了充满偏见的真实世界,这种减轻训练偏见的努力又反过来破坏AI辅助社会科学研究的有效性。最后,对生成式人工智能的人工引导还需要考虑外部有效性和内部有效性之间的权衡。生成式人工智能技术在不同的文化内容上进行训练,通过模拟类似人类的反应和泛化到现实世界的场景来提供更大的外部有效性。然而,它们的不透明性将限制其内部有效性;相反,建立在较小的受控数据集上的研究可以提供更强的内部有效性,但代价是可靠性和泛化性降低,因为有限的训练数据可能会阻碍它们在不同环境中一致和广泛的执行能力。因此,研究人员应根据自己的优先事项在这些方法之间仔细选择。

,