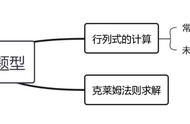

矩阵加法

学习两个m×n矩阵的加法相当于学习输入和输出位置之间的对应关系(如在转置问题中),以及在mn对元素上执行浮点表示中两个数字相加的算法。作者对此训练了 1 层或 2 层、8 个注意力头和 512 个维度的 Transformer。

对于大小不超过 10 的固定大小矩阵的加法,包括n=m和n≠m两种情况,在 1% 的容差范围达到99% 准确率(并且在 0.5% 内超过 98%)。FP15 模型在 15×15 矩阵的 0.5% 容差内实现了 99.5% 准确率,而 B1999 模型在 20×20 矩阵上实现了 89.7% 准确率和 1% 的容差。

维度高达 10 的可变大小矩阵由 2 层Transformer使用 B1999 编码预测,准确率超过 99.5%,容差为 1%。编码器中有一层,解码器中有 6 层的模型在相同的数据集上实现了 77% 和 87% 的准确率。下图总结了实验结果。

矩阵乘法

维数为m×n的矩阵M与向量

相当于计算V和M之间的m个点积。

每次点积计算包含n个乘法和n − 1 个加法,涉及矩阵中的其中一行和向量中的所有系数。模型必须了解这2n个元素在计算中的位置,以及两个运算(加法和乘法)。

通过对1 层或2 层、超过5×5矩阵的模型进行实验,作者观察到P10和P1000编码的模型才能训练到高精度。P1000编码性能最好,两层和一层模型之间差别不大。对于5×5和10×10平方矩阵,采用P1000编码的2层Transformer可实现99.9%以上的精度,容差为1%。结果汇总在下图中。

矩阵M和P的乘法是矩阵向量乘法的进阶版本,其对矩阵 P 中的每一列向量执行上述运算。和以前一样,只有使用P10和P1000的编码模型才能训练高精度预测。

超过5×5矩阵和类似大小的矩形矩阵,训练模型精度与向量乘法相同(在 1% 容差下超过 99%),但需要更深的解码器(4 到 6 层)。

特征值

我们把注意力转向由迭代算法解决的非线性问题。

作者在编码器或解码器中训练 4 层或 6 层的模型,用以预测对称矩阵的特征值。

对于 5×5 随机矩阵的样本,在 5% 的容差下达到 100% 的准确率,在所有四种编码下达到 98.5% 的 1%。对于 8×8 矩阵,在 5% 和 1% 的容差下实现了 100% 和 85% 的准确率。

但也遇到了瓶颈,对于大规模问题,模型难以学习:在 10×10 矩阵上,3.6 亿个示例可达 25% 的准确率和 5% 的容差。相比之下,对于5×5矩阵,模型在大约 4000 万个样本中训练到最高准确率,对于8×8矩阵,模型在大约 6000 万个样本中训练到最高准确率。

这个限制通过在可变大小的数据集上训练模型能够克服。在维度为 5-10、5-15 和 5-20 的矩阵样本上,模型在 5% 的容差下达到 100% 的准确率,在 1% 容差下达到 88%、94% 和 45%。使用 5-15 模型,10×10 矩阵的特征值可以在 2% 的容差下以 100% 的准确率进行预测,在 1% 容差时为 73%。结果如下图所示。