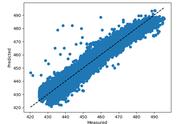

R方=0.91 模型在一定程度较好的拟合数据(91%)

R方<0 拟合直线的趋势与真实因变量相反

调整R方(适用多元线性回归):

一般的R方会存在一些问题,即把任意新的自变量加入到线性模型中,都可能会提升R方的值,模型会因加入无价值的变量导致R方提升,对最终结果产生误导。

故在建立多元线性回归模型时,我们把R方稍稍做一些调整,引进数据量、自变量个数这两个条件,辅助调整R方的取值,我们把它叫调整R方;调整R方值会因为自变量个数的增加而降低(惩罚),会因为新自变量带来的有价值信息而增加(奖励);可以帮助我们筛选出更多有价值的新自变量。

- n:数据量大小(行数)->数据量越大,新自变量加入所影响越小;

- p:自变量个数->自变量个数增加,调整R方变小,对这个量进行惩罚;

一句话,调整R方不会因为模型新增无价值变量而提升,而R方会因为模型新增无价值变量而提升!通过观测调整R方可以在后续建模中去重多重共线性的干扰,帮助我们选择最优自变量组合。

R方/调整R方值区间经验判断:

- <0.3->非常弱的模型拟合

- 0.3-0.5->弱的模型拟合

- 0.5-0.7->适度的模型拟合

- >0.7->较好的模型拟合

我们以共享单车服务满意分数据为案例进行模型实战,想要去分析不同的特征对满意分的影响程度,模型过程如下:

1. 读取数据

2. 切分因变量和自变量、分类变量转换哑变量

3. 使用VIF去除多重共线性

多重共线性:就是在线性回归模型中,存在一对以上强相关变量,多重共线性的存在,会误导强相关变量的系数值。

强相关变量:如果两个变量互为强相关变量,当一个变量变化时,与之相应的另一个变量增大/减少的可能性非常大。

当我们加入一个年龄强相关的自变量车龄时,通过最小二乘法所计算得到的各变量系数如下,多重共线性影响了自变量车龄、年龄的线性系数。

这时候,可以使用VIF消除多重共线性:VIF=1/(1-R方),R方是拿其他自变量去线性拟合此数值变量y得到的线性回归模型的决定系数。某个自变量造成强多重共线性判断标准通常是:VIF>10